Im letzten Teil unserer Serie haben wir uns mit der demokratisierenden Kraft von Large Language Models (LLMs) und ihrem Potenzial, die Machtverhältnisse in der KI-Branche neu zu gestalten, beschäftigt. Doch wie bei vielen transformativen Technologien bedeutet der generalistische Charakter dieser Modelle, dass sie zwar ein enormes Potenzial haben, aber spezifische Anpassungen an die jeweiligen Bedürfnisse erfordern.

Open-Source-LLMs, so leistungsfähig sie auch sind, werden oft als Breitbandlösungen angeboten. Um ihre Effizienz und Relevanz zu maximieren, müssen sie für bestimmte Anwendungen angepasst werden. Dieser Artikel befasst sich mit solchen Anpassungen und beleuchtet Techniken wie Fine-tuning, Prompt-Engineering und die faszinierende Retrieval-Augmented Generation (RAG). Durch diese Erkundung wollen wir den Lesern das Wissen vermitteln, das sie benötigen, um das wahre Potenzial von LLMs in ihrem spezifischen Kontext zu nutzen.

Tauchen Sie mit uns in die Kunst und Wissenschaft der Anpassung von Open-Source-LLMs ein und schaffen Sie die Voraussetzungen für ein breiteres Verständnis und eine höhere Wertschätzung der Welt der Open-Source-KI.

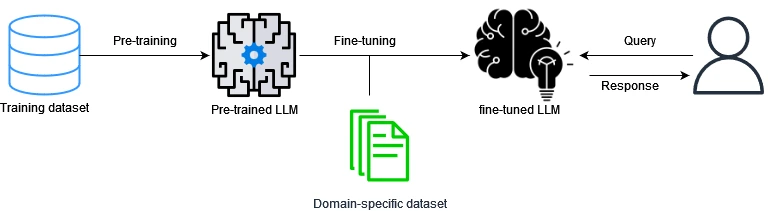

Fine-tuning: Jenseits der Fundamente

In der Welt der LLMs gibt es keine Einheitsgröße, die für alle passt. Hier kommt die Fine-tuning ins Spiel, ein Prozess, der ein allgemeines KI-Modell in einen aufgabenspezifischen Experten verwandelt. Im Grunde ist die Fine-tuning vergleichbar mit einem Allgemeinmediziner, der eine Facharztausbildung zum Kardiologen oder Neurologen absolviert – er verfügt über die Grundlagen, muss aber sein Fachwissen auf den spezifischen Kontext abstimmen.

- Die Grundlage: Die meisten LLMs werden bei ihrer ersten Ausbildung mit großen Mengen an Textdaten konfrontiert, wodurch sie Grammatik, Fakten über die Welt und ein gewisses Maß an logischem Denken lernen können. Diese breite Wissensbasis bildet das Fundament.

- Die Spezialisierung beginnt: Um dieses allgemeine Wissen an eine bestimmte Anwendung anzupassen, wird das Modell zusätzlich auf einem engeren, für die Aufgabe relevanten Datensatz trainiert. Um beispielsweise einen Bot für Rechtsassistenten zu entwickeln, könnte ein LLM auf juristische Dokumente und Rechtsprechung abgestimmt werden.

Varianten des Fine-Tuning:

- Vollständige Fine-tuning: Dies ist die herkömmliche Methode, bei der das gesamte Modell, unabhängig von seiner Größe, auf neuen Daten trainiert wird. Alle Parameter werden an die jeweilige Aufgabe angepasst. Dies ist zwar effektiv, kann aber rechenintensiv und zeitaufwändig sein, insbesondere bei umfangreichen Modellen wie vielen LLMs.

- Parametereffiziente Fine-Tuning (PEFT): Eine moderne Technik, die darauf abzielt, die gewünschte Leistung mit einer geringeren Anzahl von Parametern zu erreichen. Diese Methode ist besonders wichtig, um die Rechenkosten niedrig zu halten, vor allem wenn man mit großen Modellen arbeitet. Wir werden PEFT und seine Feinheiten in einem späteren Artikel dieser Serie näher beleuchten.

Warum sollten Sie sich für Fine-Tuning entscheiden? Denn es nutzt das Wissen, über das ein Modell bereits verfügt (das anhand umfangreicher Datensätze trainiert wurde), und passt es an spezifische Aufgaben an. Diese Technik verkürzt die Lernkurve erheblich und stellt sicher, dass das Modell nicht bei Null anfängt, sondern auf einem etablierten Fundament aufbaut. Darüber hinaus können Unternehmen durch den Einsatz von Varianten wie PEFT eine solide Leistung erzielen, ohne exorbitante Rechenkosten zu verursachen.

- Maßgeschneiderte Lösungen: Jedes Unternehmen ist einzigartig, und dank der Fine-tuning können KI-Lösungen diese Einzigartigkeit widerspiegeln.

- Wirtschaftlich: Der Aufbau eines LLM von Grund auf ist ressourcenintensiv. Die Fine-tuning ist eine kostengünstige Alternative.

- Effizienz: In der sich schnell entwickelnden Welt der KI ist Zeit das A und O. Die Fine-tuning ist schneller als eine umfassende Schulung und bietet eine zeitnahe Lösung.

- Nutzung von vorhandenem Wissen: Wenn Sie mit einem vortrainierten Modell beginnen, fangen Sie nicht bei Null an. Sie bauen auf vorhandenem Fachwissen auf.

Vorteile der Fine-tuning:

- Schnelle Anpassung: Schnelligkeit ist von entscheidender Bedeutung, und die Fine-tuning ist wesentlich schneller als das Training eines Modells von Grund auf.

- Kosteneffizienz: Es ist wirtschaftlich klüger, ein bereits bestehendes Modell anzupassen, als eines von Grund auf neu zu entwickeln.

- Vielseitigkeit: Von Bots für den Kundenservice bis hin zu prädiktiven Analysetools kann ein Basismodell unzählige Spezialanwendungen hervorbringen.

Herausforderungen der Fine-tuning:

- Qualität ist wichtig: Der Output ist nur so gut wie der Input. Verzerrte oder fehlerhafte Daten für die Fine-tuning führen zu unvollkommenen Ergebnissen.

- Balanceakt: Es besteht die Gefahr, dass das Modell zu sehr spezialisiert wird und dadurch ein Teil seines Allgemeinwissens verloren geht.

Mit einem Verständnis für die Fine-tuning können Unternehmen die KI-Landschaft strategischer navigieren und den richtigen Ansatz für ihre spezifischen Bedürfnisse und Herausforderungen wählen.

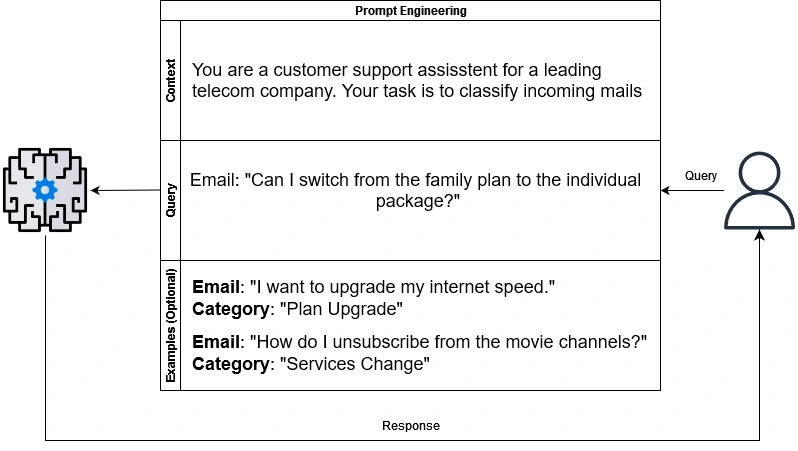

Prompt-Technik: Gestaltung von Fragen für intelligentere KI

Da KI in unserer Welt eine immer größere Rolle spielt, kommt es nicht nur darauf an, ein intelligentes Modell zu haben, sondern auch zu wissen, wie man ihm die richtigen Fragen stellt. Hier kommt das Prompt-Engineering ins Spiel.

Einführung in das Prompt Engineering:

Auch wenn es sich kompliziert anhört, ist Prompt-Engineering im Wesentlichen die Kunst, Eingaben oder „Prompts“ so zu gestalten, dass die gewünschten Ergebnisse eines Modells erzielt werden. Stellen Sie sich vor, Sie stellen eine Frage auf verschiedene Arten, um die genaueste Antwort zu erhalten. Anstelle der Frage „Was ist die Hauptstadt Frankreichs?“ könnte eine Frage lauten: „Welche Stadt ist der offizielle Sitz der französischen Regierung?“

Die Macht der Prompts:

Durch die Umstrukturierung unserer Fragen können wir dem Modell präzisere oder nuanciertere Antworten entlocken. Dazu muss das Modell nicht unbedingt neu trainiert werden. Stattdessen geht es darum, das bestehende Modell zu besseren Schlussfolgerungen zu führen, indem die Frage besser formuliert wird. In vielen Fällen kann die richtige Aufforderung den Unterschied zwischen einer allgemeinen Antwort und einer differenzierten, detaillierten Antwort ausmachen.

Herausforderungen und Beschränkungen:

Das Prompt-Engineering ist jedoch nicht ohne Herausforderungen. Das Finden des richtigen Prompts ist oft mit Versuch und Irrtum verbunden, und während ein Prompt bei einem Modell gut funktioniert, ist er bei einem anderen vielleicht nicht so effektiv. Außerdem kann ein übermäßiger Rückgriff auf diese Technik zu einer Überanpassung führen, bei der das Modell zu sehr auf bestimmte Aufforderungen zugeschnitten ist und seine Verallgemeinerungsfähigkeit einbüßt.

Warum sollten Sie Prompt Engineering nutzen?

Trotz seiner Herausforderungen nimmt das Prompt-Engineering einen besonderen Platz in der Welt der KI-Anpassung ein. Dies ist eine kosteneffiziente Methode, um mehr aus den Modellen herauszuholen, ohne dass eine umfangreiche Umschulung erforderlich ist. In Szenarien, in denen Rechenressourcen oder Daten begrenzt sind, bietet das Prompt-Engineering eine praktikable Alternative, um das volle Potenzial eines LLM auszuschöpfen.

Fortgeschrittene Strategien im Prompt Engineering

1. Zero-Shot-, Few-Shot- und Many-Shot-Lernen:

- Zero-Shot-Learning: Dies bezieht sich auf die Fähigkeit eines LLM, Aufgaben auszuführen, für die es nicht ausdrücklich trainiert wurde. Nehmen wir an, Sie haben ein Modell auf eine Fülle von Allgemeinwissen trainiert, aber nie speziell auf die Identifizierung seltener Vogelarten. Wird dem Modell jedoch eine Beschreibung eines seltenen Vogels vorgelegt, kann es diesen aufgrund seiner umfassenden Kenntnisse und der Korrelation mit bekannten Daten korrekt identifizieren.

- Few-Shot-Learning: Hier erhält der LLM einige Beispiele, um eine neue Aufgabe zu verstehen. Indem gezeigt wird, wie ähnliche Aufgaben angegangen wurden, erhält das Modell einen „Hinweis“ und ist besser in der Lage, neue, verwandte Aufgaben anzugehen. Stellen Sie sich vor, Sie möchten mit Ihrem Modell Rezepte erstellen. Sie geben ihm eine Handvoll Beispiele wie „Zutat: Apfel, Gericht: Kuchen“ und fordern es dann mit „Zutat: Huhn“ auf. Das Modell könnte dann ein Gericht mit Huhn zubereiten, nachdem es die Aufgabe anhand der wenigen Beispiele verstanden hat.

- Many-Shot Learning: Wie der Name schon sagt, geht es darum, dem LLM zahlreiche Beispiele zu geben. Wenn Sie Zusammenfassungen von technischen Forschungsarbeiten erhalten möchten, können Sie dem Modell Dutzende von Beispielen für Forschungsarbeiten und deren kurze Zusammenfassungen vorlegen. Bei einer neuen Arbeit wird das Modell besser in der Lage sein, eine Zusammenfassung zu erstellen, die denselben Stil und dieselbe Kürze aufweist wie die Beispiele.

2. Ansatz der Gedankenkette (Chain-of-Thoughts):

Manchmal reicht eine einzige Aufforderung nicht aus. Der Ansatz der „Chain of Thoughts“ beinhaltet die Erstellung einer Reihe von Aufforderungen, wobei jede nachfolgende Abfrage auf der vorherigen aufbaut. Dies ist vergleichbar mit einem Gespräch, bei dem die Informationen nach und nach aufgeschichtet werden, so dass komplizierte Details herausgefiltert werden können oder eine tiefer gehende Erforschung eines Themas möglich ist. Denken Sie an eine detaillierte Erklärung eines komplexen Themas wie der Quantenverschränkung. Die erste Aufforderung könnte eine einfache Frage sein: „Was ist Quantenverschränkung?“ Ausgehend von der Antwort des Modells könnte eine Folgeuntersuchung tiefer gehen und fragen: „Wie korreliert das mit der Quantenüberlagerung?“ Diese sequentielle Aufforderung kann zu einem umfassenderen, vielschichtigen Verständnis führen.

Nutzung fortgeschrittener Prompting-Techniken:

Die Anwendung dieser fortschrittlichen Strategien kann einen entscheidenden Unterschied machen. Sie bieten einen dynamischen Ansatz, um die Fähigkeiten von LLMs zu nutzen und gewährleisten eine ganzheitlichere, nuanciertere Reaktion des Modells. Dies ist besonders wichtig in Szenarien, in denen eine Fine-tuning nicht möglich ist oder in denen eine eher explorative, organische Interaktion mit dem Modell gewünscht wird.

Vorteile von Prompt Engineering:

- Flexibilität: Prompting bietet einen dynamischen Ansatz, um die gewünschten Ergebnisse von Modellen zu erhalten, ohne dass ein erneutes Training erforderlich ist. Dies ist besonders nützlich, wenn der Benutzer verschiedene Antworten auf der Grundlage unterschiedlicher Szenarien benötigt.

- Schnelle Anpassung: Beim Lernen mit wenigen oder vielen Schüssen können sich die Modelle schnell an neue Aufgaben anpassen, so dass es einfacher ist, das Verhalten ohne einen umfassenden Feinabstimmungsprozess zu ändern.

- Ressourceneffizienz: Im Vergleich zum Nachtrainieren von Modellen ist das Prompt-Engineering oft rechnerisch effizienter. Es ermöglicht schnelle Anpassungen und Änderungen ohne großen Ressourcenaufwand.

- Iteratives Lernen: Der Chain-of-Thoughts-Ansatz erleichtert ein tieferes Verständnis, indem er komplexe Fragen iterativ in einfachere, aufeinander folgende Abfragen zerlegt, die dem Modell helfen, eine differenzierte Antwort zu finden.

Herausforderungen der Prompt Engineering:

- Konsistenz: Es kann eine Herausforderung sein, für unterschiedliche Eingaben konsistente Ergebnisse zu erzielen. Ein und dieselbe Aufforderung kann manchmal zu unterschiedlichen Antworten führen, wenn die Eingabeformulierung leicht verändert wird.

- Skalierbarkeit: Während die Eingabeaufforderung für einzelne Aufgaben oder Abfragen gut funktioniert, kann die Skalierung für große Datensätze oder umfassende Aufgaben eine Herausforderung darstellen, insbesondere wenn eine einheitliche Ausgabe für alle Eingabeaufforderungen erforderlich ist.

- Fachwissen erforderlich: Die Erstellung effektiver Prompts, insbesondere für fortgeschrittene Strategien wie Chain of Thoughts, erfordert ein tiefes Verständnis des Modells und der jeweiligen Aufgabe.

- Übermäßiges Vertrauen: Wenn man sich ausschließlich auf das Prompting verlässt, kann es passieren, dass man die potenziellen Vorteile anderer Techniken wie der Fine-tuning verpasst, vor allem, wenn die Aufgabe umfangreiche Änderungen im Modellverhalten erfordert.

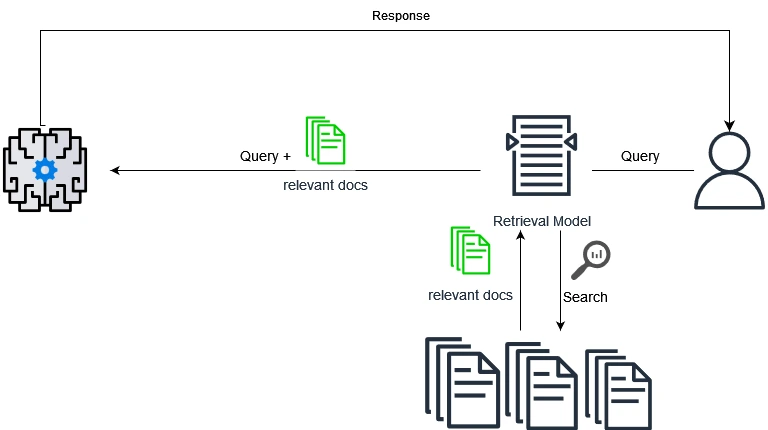

Retrieval-Augmented Generation (RAG)

Einführung in die RAG:

Retrieval-Augmented Generation (RAG) kombiniert das Beste aus Retrieval-basierten und generativen Methoden, um Fragen zu beantworten. Im Kern nutzt RAG externe Wissensquellen, oft große Datenbanken oder Korpora, um eine Antwort zu generieren. Wenn eine Frage gestellt wird, ruft das Modell zunächst relevante Dokumentenpassagen aus seiner Datenbank ab und formuliert dann eine kohärente und kontextbezogene Antwort unter Verwendung dieser Passagen.

Wie die RAG funktioniert:

- Abfrage-Phase: Wenn eine Anfrage gestellt wird, identifiziert RAG zunächst relevante Passagen oder Dokumente aus einem umfangreichen Korpus, die Kontext oder Erkenntnisse zur Beantwortung der Anfrage liefern könnten.

- Generierungsphase: Unter Verwendung der abgerufenen Dokumente als Kontext generiert das Modell dann eine kohärente Antwort. Dieses Verfahren stellt sicher, dass die Antworten nicht nur auf dem vorab trainierten Wissen des Modells basieren, sondern auch auf den neuesten und relevantesten Daten aus externen Quellen.

Beispiele:

- Faktenbasierte Fragen: Wenn jemand fragt: „Was sind die Hauptursachen für das Nordlicht?“, könnte die RAG wissenschaftliche Artikel oder vertrauenswürdige Datenbanken über atmosphärische Phänomene abrufen, um eine detaillierte und genaue Antwort zu geben.

- Aktualisierungen von Ereignissen: Auf Fragen wie „Was waren die Ergebnisse der jüngsten Klimakonferenz?“ könnte die RAG Informationen aus aktuellen Nachrichtenartikeln oder offiziellen Zusammenfassungen von Konferenzen entnehmen, um eine aktuelle Antwort zu geben.

Vorteile der RAG:

- Datengesteuerte Antworten: Der Ansatz von RAG stellt sicher, dass die Antworten nicht nur auf den vortrainierten Daten des Modells basieren, sondern auch auf aktuellen und kontextrelevanten Informationen in Echtzeit.

- Ausgewogener Ansatz: Durch die Kombination von Abrufen und Generieren schafft RAG ein Gleichgewicht zwischen Genauigkeit (durch Abrufen von Sachdaten) und Geläufigkeit (durch Generieren kohärenter Antworten).

- Skalierbarkeit: Mit einer externen Datenbank kann das System ständig mit neuen Informationen aktualisiert werden, so dass das Modell im Laufe der Zeit relevant bleibt, ohne dass eine ständige Nachschulung erforderlich ist.

Herausforderungen der RAG:

- Abhängigkeit von externen Daten: Die Genauigkeit und Relevanz der Antworten des Modells hängen stark von der Qualität der externen Datenbank ab.

- Komplexität: Die Implementierung von RAG erfordert die Verwaltung von Abruf- und Generierungsprozessen, was die Komplexität des Systems erhöhen kann.

- Latenzzeit: Der zweistufige Prozess, insbesondere beim Zugriff auf große Datenbanken, kann zu einer Latenz bei der Generierung von Antworten führen, was für Echtzeitanwendungen problematisch sein kann.

Die Wahl der richtigen Technik für Ihre Bedürfnisse

Wir haben zwar verschiedene Techniken zur Anpassung von Open-Source-LLMs untersucht, aber die Frage, die sich oft stellt, ist: „Welche Technik ist die richtige für mein Projekt?“ Die Antwort hängt weitgehend von Ihren spezifischen Anforderungen ab:

- Fine-tuning: Am besten geeignet für Projekte, die einen bestimmten Datensatz zur Verfügung haben und eine maßgeschneiderte Modellleistung anstreben. Diese Methode ist besonders vorteilhaft, wenn die Leistung eines vortrainierten LLM für die Aufgabe nicht zufriedenstellend ist.

- Prompt Engineering: Eine gute Wahl für Aufgaben, die einen allgemeineren Ansatz erfordern, insbesondere wenn die verfügbaren Daten für das Training knapp sind. Wenn Sie schnell Ergebnisse erzielen wollen, ohne den Aufwand einer Modellschulung zu betreiben, kann Prompting ein wirkungsvolles Instrument sein.

- Retrieval-Augmented Generation (RAG): Optimal für Projekte, die eine Kombination aus Wissensabfrage und -generierung erfordern. Wenn Ihre Anwendung die Beschaffung von Informationen aus großen Datenbeständen oder Dokumenten und die anschließende Generierung einer zusammenhängenden Antwort erfordert, ist RAG die richtige Technik für Sie.

Die obigen Angaben sind jedoch nur eine grundlegende Richtlinie. Die Besonderheiten Ihres Projekts, die Datenverfügbarkeit, die Rechenressourcen und die gewünschten Ergebnisse spielen bei der Entscheidungsfindung eine wichtige Rolle. Bleiben Sie dran für unsere nächsten Artikel, in denen wir auf die Feinheiten der einzelnen Methoden eingehen und Ihnen helfen, noch fundiertere Entscheidungen zu treffen.

Zusammenfassung

Da sich die KI-Landschaft ständig weiterentwickelt, müssen sich auch die Techniken, mit denen wir die Leistung von großen Sprachmodellen nutzen können, weiterentwickeln. Fine-tuning, zeitnahes Engineering und RAG bieten jeweils einzigartige Vorteile, die auf spezifische Herausforderungen und Ziele abgestimmt sind. Ob es sich nun um die präzise Kalibrierung eines Modells für bestimmte Aufgaben durch Fine-tuning, die Vielseitigkeit und Anpassungsfähigkeit, die das Prompt-Engineering bietet, oder die Dynamik und reale Anwendbarkeit, die durch RAG erreicht wird, handelt, diese Techniken stellen die nächste Grenze der LLM-Anpassung dar.

Da Open-Source-LLMs immer beliebter werden, ist das Verständnis dieser Techniken für Unternehmen und Entwickler, die auf der Welle der KI-Demokratisierung mitreiten wollen, von entscheidender Bedeutung. Es geht nicht nur um den Zugang zu leistungsstarken Modellen, sondern auch darum, sie effektiv auf reale Anwendungen zuzuschneiden.

In den kommenden Artikeln werden wir uns näher mit den Nuancen dieser Techniken, ihrer Effizienz und ihren Auswirkungen auf die Nachhaltigkeit befassen. Das Zeitalter der barrierefreien KI ist angebrochen, und die Werkzeuge, um ihr Potenzial zu nutzen, liegen direkt vor unserer Nase. Begleiten Sie uns auf dieser Reise, auf der wir erforschen, anpassen und erneuern.